转载自https://www.cnblogs.com/LoyenWang/p/11523678.html

1. 介绍

顺着之前的分析,我们来到了bootmem_init()函数了,本以为一篇文章能搞定,大概扫了一遍代码之后,我默默的把它拆成了两部分。bootmem_init()函数代码如下:

void __init bootmem_init(void)

{

unsigned long min, max;

min = PFN_UP(memblock_start_of_DRAM());

max = PFN_DOWN(memblock_end_of_DRAM());

early_memtest(min << PAGE_SHIFT, max << PAGE_SHIFT);

max_pfn = max_low_pfn = max;

arm64_numa_init();

/*

* Sparsemem tries to allocate bootmem in memory_present(), so must be

* done after the fixed reservations.

*/

arm64_memory_present();

sparse_init();

zone_sizes_init(min, max);

memblock_dump_all();

}

这一部分,我们将研究一下Sparse Memory Model。

在讲Linux内存模型之前,需要补充两个知识点:PFN和NUMA

1.1 physical frame number(PFN)

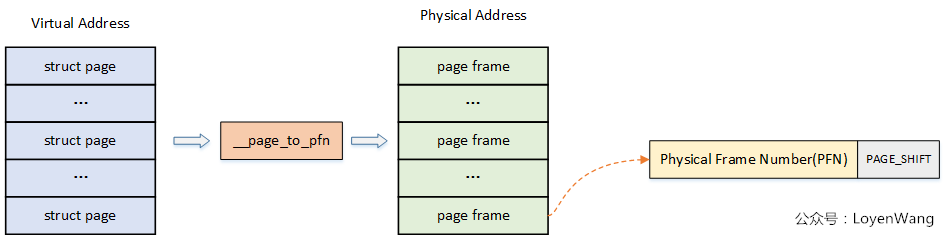

前面我们讲述过了虚拟地址到物理地址的映射过程,而系统中对内存的管理是以页为单位的:

page:线性地址被分成以固定长度为单位的组,称为页,比如典型的4K大小,页内部连续的线性地址被映射到连续的物理地址中;

page frame:内存被分成固定长度的存储区域,称为页框,也叫物理页。每一个页框会包含一个页,页框的长度和一个页的长度是一致的,在内核中使用struct page来关联物理页。

如下图,PFN从图片中就能看出来了:

至于__page_to_pfn这个实现取决于具体的物理内存模型,下文将进行介绍。

1.2 NUMA

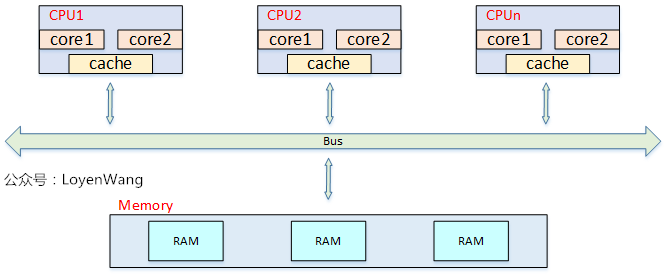

- UMA: Uniform Memory Access,所有处理器对内存的访问都是一致的:

从上图中可以看出,当处理器和Core变多的时候,内存带宽将成为瓶颈问题。

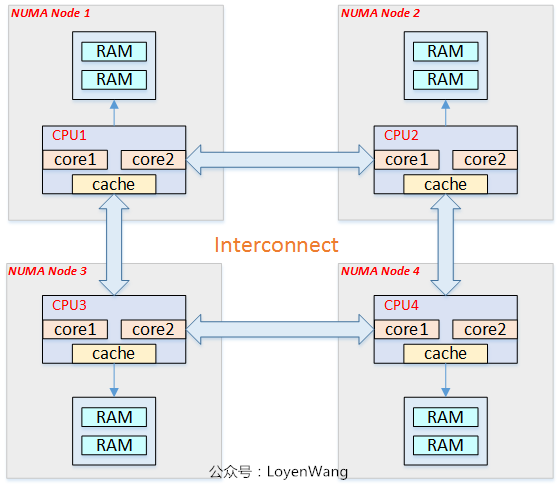

- NUMA: Non Uniform Memory Access,非一致性内存访问:

从图中可以看出,每个CPU访问local memory,速度更快,延迟更小。当然,整体的内存构成一个内存池,CPU也能访问remote memory,相对来说速度更慢,延迟更大。目前对NUMA的了解仅限于此,在内核中会遇到相关的代码,大概知道属于什么范畴就可以了。

2. Linx内存模型

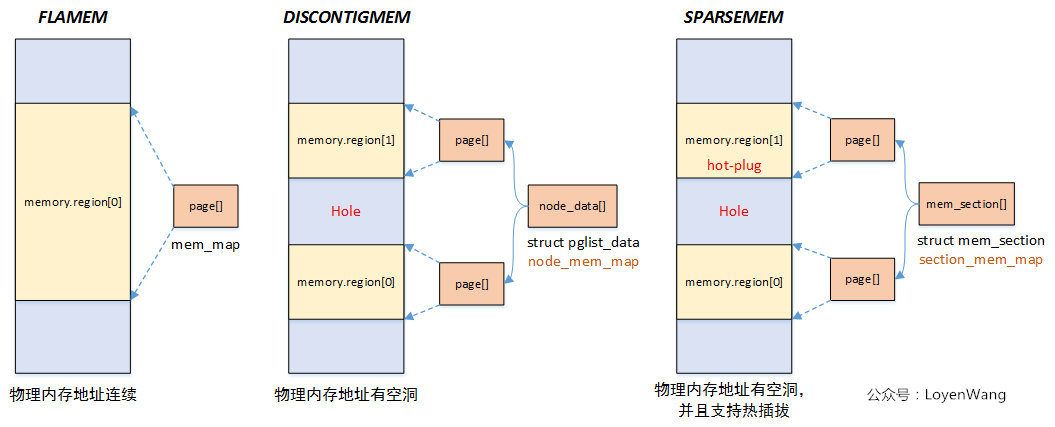

Linux提供了三种内存模型(include/asm-generic/memory_model.h):

一般处理器架构支持一种或者多种内存模型,这个在编译阶段就已经确定,比如目前在ARM64中,使用的Sparse Memory Model。

- Flat Memory

物理内存地址连续,这个也是Linux最初使用的内存模型。当内存有空洞的时候也是可以使用这个模型,只是struct page *mem_map数组的大小跟物理地址正相关,内存有空洞会造成浪费。

- Discontiguous Memory

物理内存存在空洞,随着Sparse Memory的提出,这种内存模型也逐渐被弃用了。

- Sparse Memory

物理内存存在空洞,并且支持内存热插拔,以section为单位进行管理,这也是下文将分析的。

Linux三种内存模型下,struct page到物理page frame的映射方式也不一样,具体可以查看include/asm-generic/memory_model.h文件中的__pfn_to_page/__page_to_pfn定义。

3. Sparse Memory

本节分析的是ARM64, UMA(linux4.14中不支持ARM NUMA)下的Sparse Memory模型。

3.1 mem_section

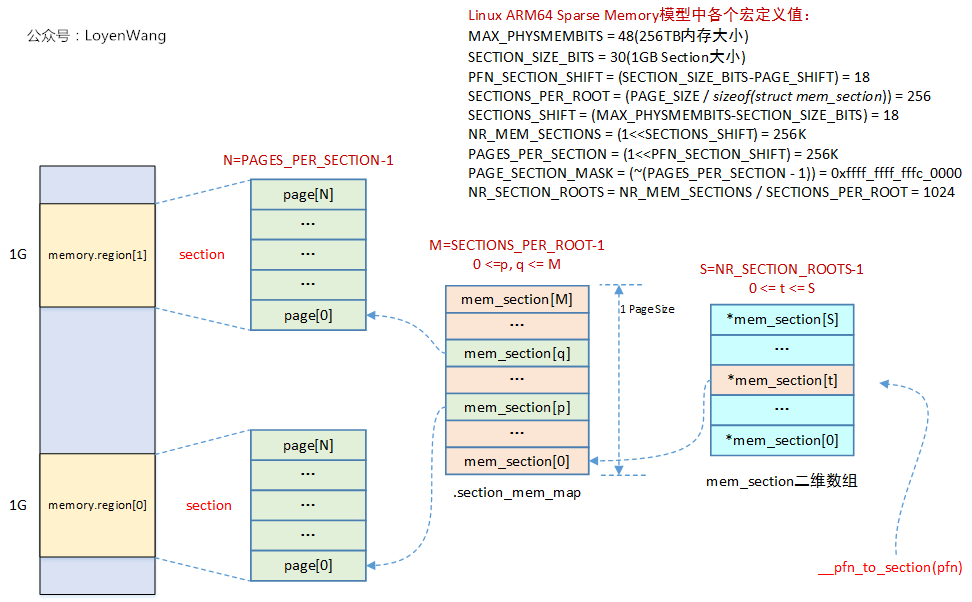

在Sparse Memory模型中,section是管理内存online/offline的最小内存单元,在ARM64中,section的大小为1G,而在Linux内核中,通过一个全局的二维数组struct mem_section **mem_section来维护映射关系。

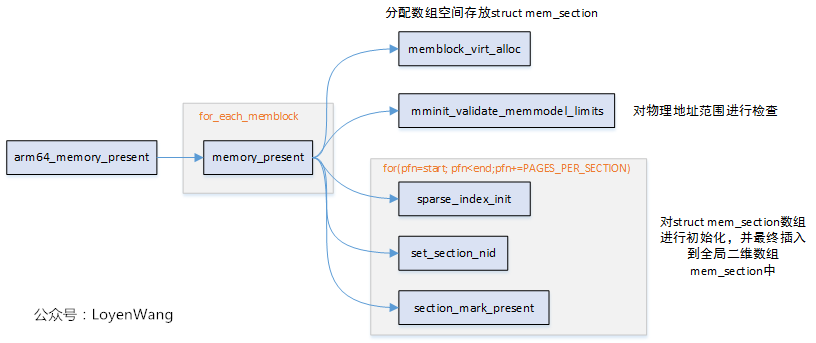

函数的调用过程如下所示,主要在arm64_memory_present中来完成初始化及映射关系的建立:

函数调用结束之后的映射关系如下图所示:

已知一个pfn时,可以通过__pfn_to_section(pfn)来最终找到对应的struct page结构。

3.2 sparse_init

看看sparse_init函数的调用关系图:

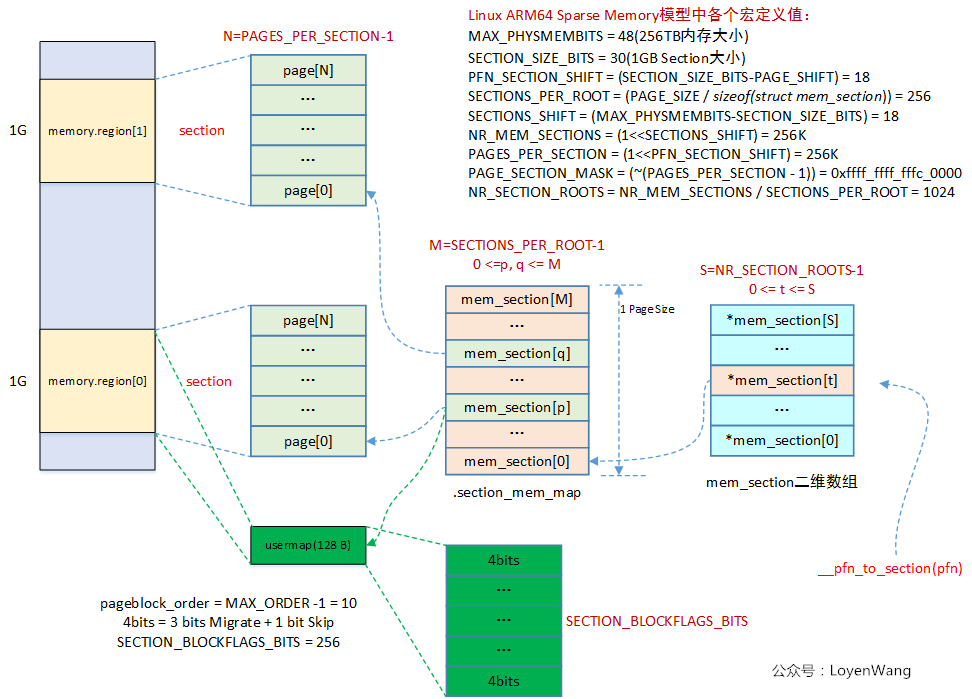

在该函数中,首先分配了usermap,这个usermap与内存的回收机制相关,用4bit的bitmap来描述page block(一个pageblock大小通常为2的次幂,比如MAX_ORDER-1)的迁移类型:

/* Bit indices that affect a whole block of pages */

enum pageblock_bits {

PB_migrate,

PB_migrate_end = PB_migrate + 3 - 1,

/* 3 bits required for migrate types */

PB_migrate_skip,/* If set the block is skipped by compaction */

/*

* Assume the bits will always align on a word. If this assumption

* changes then get/set pageblock needs updating.

*/

NR_PAGEBLOCK_BITS

};

sparse memory模型会为每一个section都分配一个usermap,最终的物理页面的压缩,迁移等操作,都跟这些位相关,如下图所示:

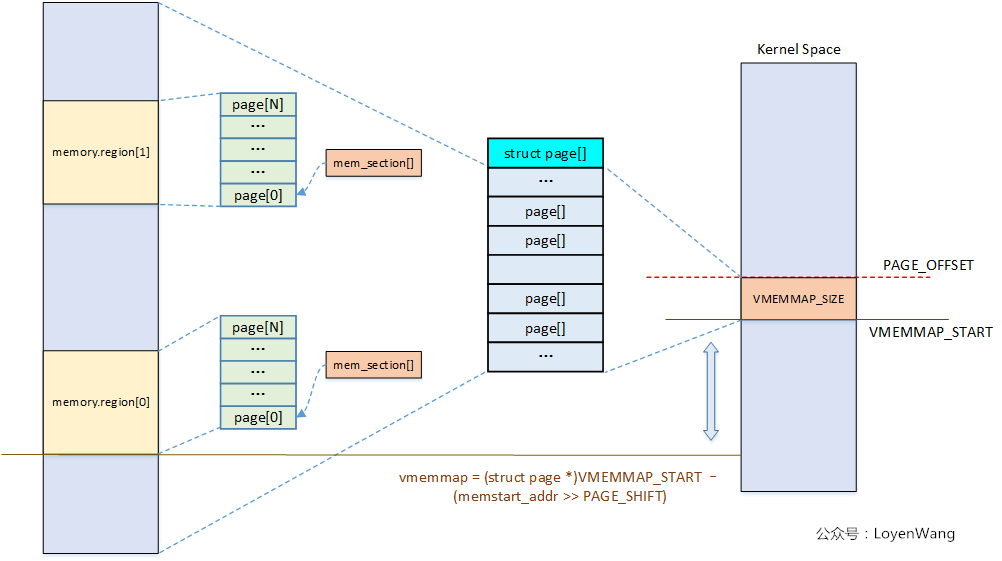

sparse_init函数中,另一部分的作用是遍历所有present section,然后将其映射到vmemmap区域空间。vmemmap区域空间,在之前的文章中也提到过。执行完后,整体的效果如下图所示:

关于Sparse Memory Model就先分析这么多,只有结合使用sparse memory的具体模块时,理解才会更顺畅。

一不小心就容易扣细节,而一旦陷入细节,内核就容易变成魔鬼,太难了。

评论 (0)